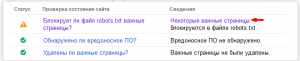

Если в Google Webmasters у вас возникла ошибка «Блокирует ли файл robots.txt важные страницы?» (вы увидели надпись «Обнаружены серьезные ошибки, связанные с состоянием сайта»). То вероятнее всего заботливая поисковая система перестала видеть дубликаты некоторых страниц, которые вы предварительно ограничили через robots.txt.

Если перейти по ссылке «Некоторые важные страницы» можно увидеть о каких именно страницах идет речь. Ничего страшного если эти страницы закрыты с целью пресечь дублирование контента. В этом случае никаких мер предпринимать не стоит, сообщение пропадет через некоторое время.

Если перейти по ссылке «Некоторые важные страницы» можно увидеть о каких именно страницах идет речь. Ничего страшного если эти страницы закрыты с целью пресечь дублирование контента. В этом случае никаких мер предпринимать не стоит, сообщение пропадет через некоторое время.

Если же вы по ошибке в robots.txt атрибутом Disallow: закрыли доступ поисковой системе к важным, с вашей точки зрения, страницам. И эти страницы должны попасть в поисковую выдачу — тогда примите меры и уберите лишние конструкции. Затем проверьте результат в разделе Сканирование -> Заблокированные URL.